WebUI

LLM

其他

gemma3

Google发布的Gemma_3全系列模型

0元/小时

v1.0

Gemma3 镜像部署教程

1. 在镜像详情界面,点击“使用该镜像创建实例”

2. 先选择GPU型号(以RTX40系为例,也可以选择镜像支持的其它型号),再点击“立即部署”

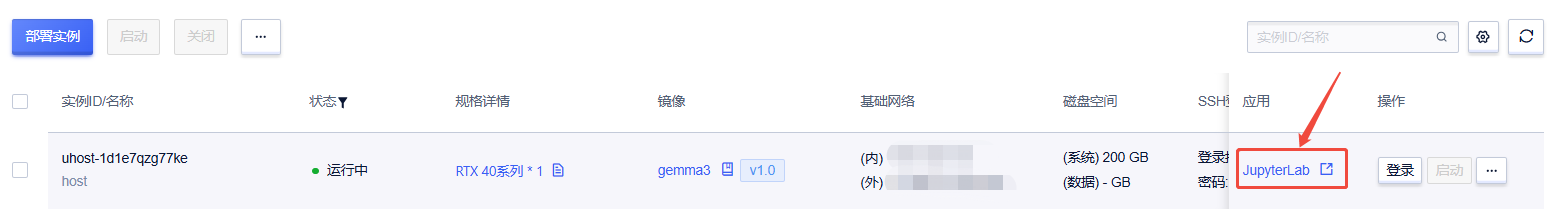

3. 待实例初始化完成后,在控制台-应用中点击“JupyterLab”

4. 进入JupyterLab后,先新建一个终端Terminal,按以下指令运行Ollama

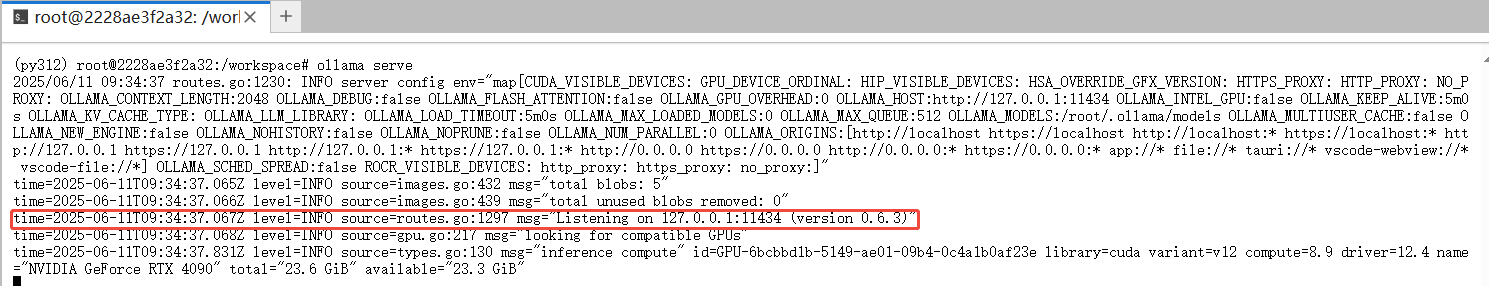

ollama serve

如图所示,成功启动 Ollama 后服务默认运行在 11434 端口

5. 不要关闭前一个终端!再新建一个终端Terminal,运行以下命令启动 Open-WebUI 服务

open-webui serve

如下图所示,Open-WebUI成功启动后,即可在浏览器中通过 ip:8080 访问Open-WebUI界面

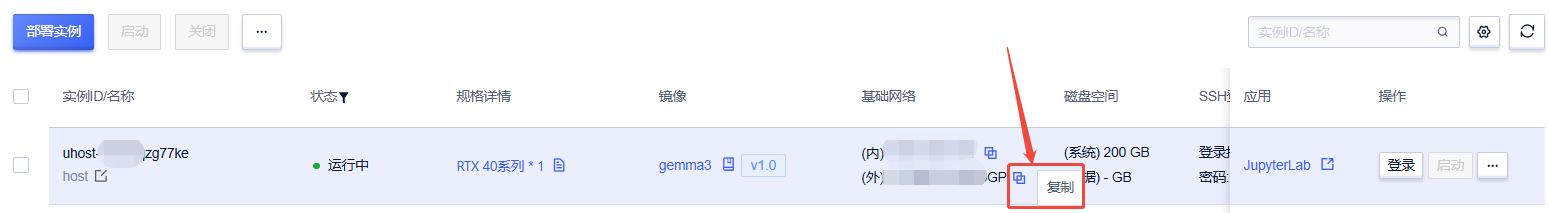

ip可以在控制台-基础网络(外)进行复制得到

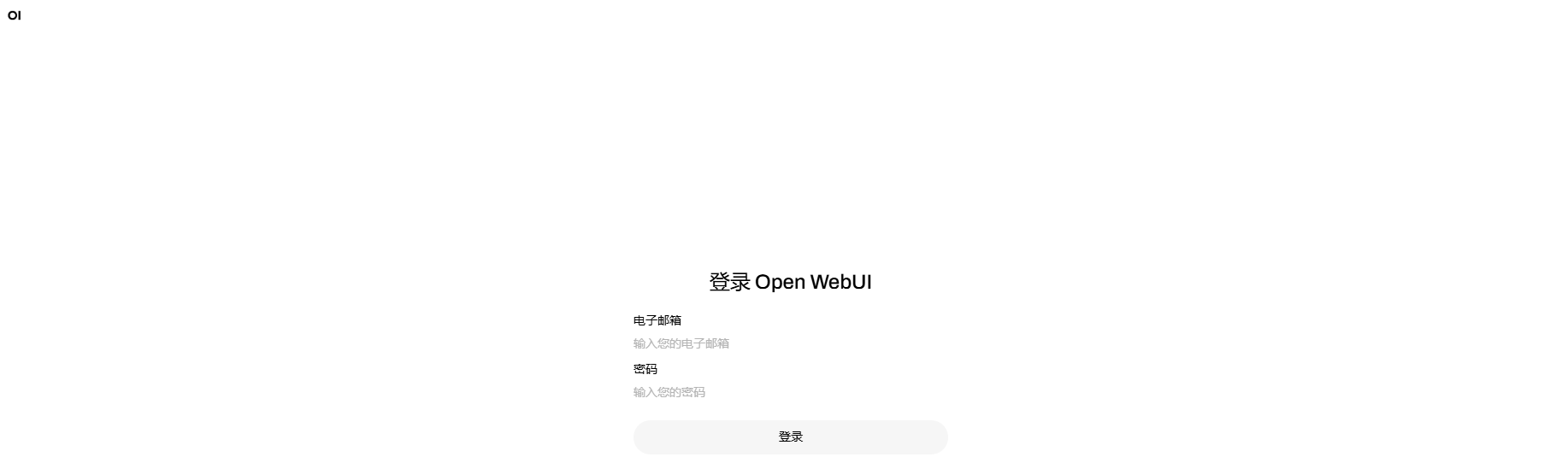

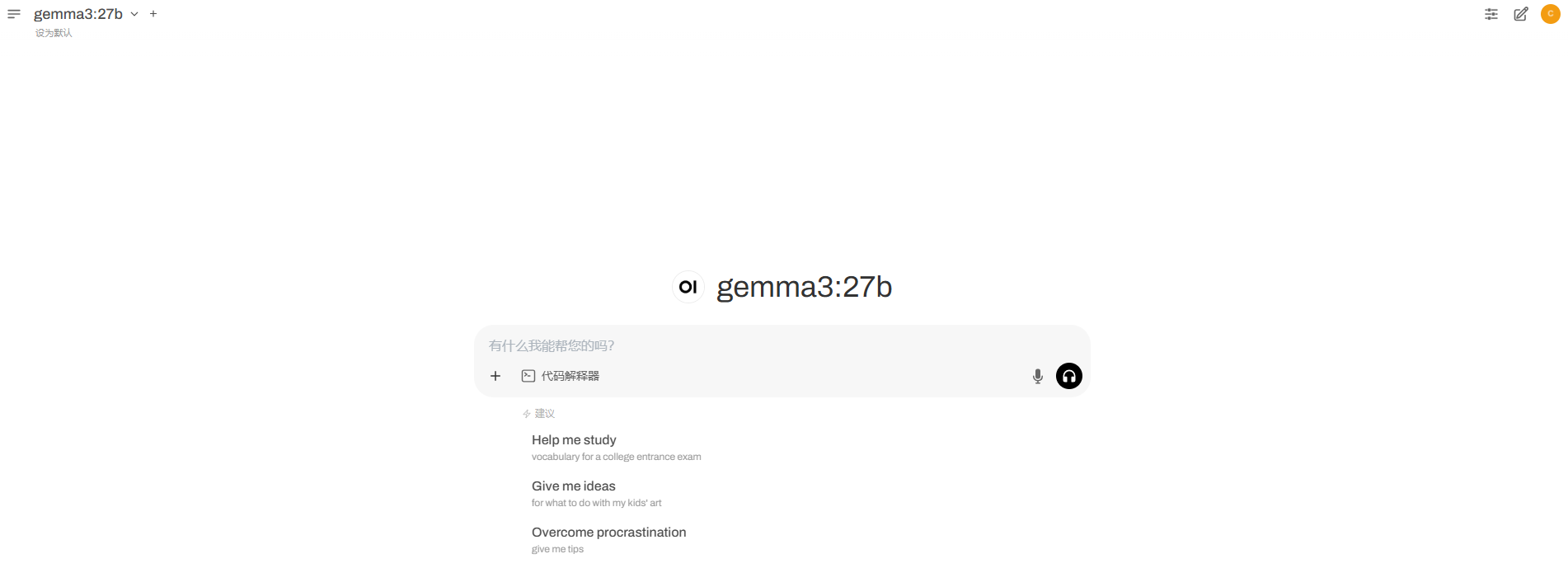

6. 进入web界面后如下图所示

输入 用户名:coderabo@qq.com 密码:coderabo 进行登录,登录之后稍等一下,出现对话框时即可开启对话

7. 重置管理员名字方法为:进入以下目录删除:webui.db,然后重启open-webui 服务即可。

/usr/local/miniconda3/envs/py312/lib/python3.12/site-packages/open_webui/data

镜像信息

@Coderabo

已使用

8

镜像大小60GB

最近编辑2025-03-31

支持卡型

RTX40系48G RTX40系2080

+3

框架版本

CUDA版本

12.1

应用

JupyterLab: 8888

版本

v1.0

2025-07-28

扫码加入用户交流群

扫码加入用户交流群